大数据架构、业务处理流程与数据处理及存储支持服务解析

在当今数据驱动的时代,有效管理和利用海量信息已成为企业核心竞争力的关键。大数据技术体系为这一目标提供了系统性解决方案,其核心在于协调一致的架构设计、高效流畅的业务处理流程,以及坚实可靠的数据处理与存储支持服务。本文将对此进行深入解析。

一、 大数据架构:构建数据处理的基石

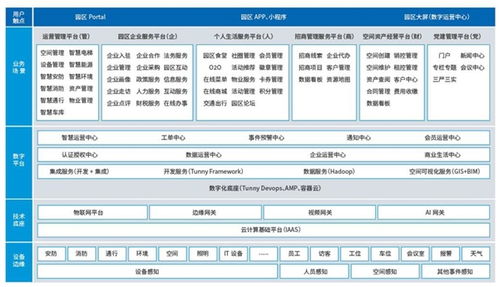

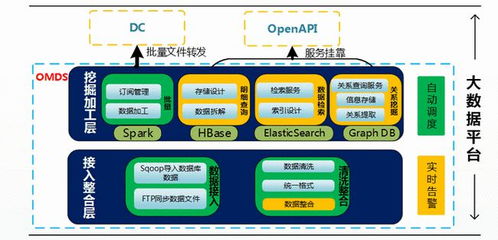

大数据架构是支撑整个数据处理体系的蓝图,它定义了数据从产生到产生价值的全链路中,各个组件的角色、功能及相互关系。现代主流的大数据架构通常采用分层设计思想,以确保系统的可扩展性、灵活性和可维护性。

- 数据源层:这是数据的起点,来源极其广泛,包括业务数据库(如MySQL、Oracle)、应用程序日志、物联网设备传感器、社交媒体流、第三方API等。这些数据具有多样性(结构化、半结构化、非结构化)、高速产生和大体量的特点。

- 数据采集与 ingestion 层:负责从各种数据源实时或批量地抽取数据,并将其安全、可靠地传输到数据存储或处理系统中。常用工具有 Apache Kafka(用于高吞吐量的实时数据流)、Flume、Sqoop(用于关系型数据库与Hadoop之间的数据传输)等。

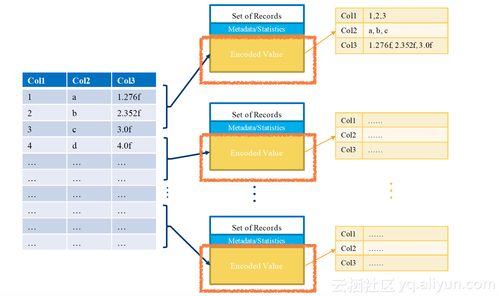

- 数据存储层:这是架构的核心,负责海量数据的持久化保存。根据数据特性和访问模式,存储方案也呈现多样化:

- 分布式文件系统:如 HDFS,适合存储原始、未经处理的巨量数据。

- NoSQL数据库:如 HBase(面向列,适合快速随机读写)、Cassandra(高可用、分布式)、MongoDB(文档型,灵活 schema),用于处理半结构化和非结构化数据。

- 数据仓库:如基于 Hive 构建的离线数仓,或 Snowflake、Amazon Redshift 等云数仓,用于存储清洗后的结构化数据,支持复杂的OLAP分析。

- 数据湖:如基于对象存储(如 AWS S3)构建的数据湖,允许以原始格式存储所有类型的数据,为后续探索性分析提供最大灵活性。

- 数据处理与计算层:这是将原始数据转化为信息和知识的核心引擎。根据时效性要求,可分为:

- 批处理:处理历史积压的大量数据,计算模型如 MapReduce,计算引擎如 Apache Spark(速度远超MapReduce)、Apache Flink(也支持流处理)。

- 流处理:处理连续不断产生的实时数据流,实现低延迟的洞察和响应,引擎如 Apache Storm、Apache Flink、Spark Streaming。

- 交互式查询:提供对海量数据的快速即席查询能力,工具如 Presto、Impala、Druid。

- 数据服务与应用层:将处理后的数据以可用形式提供给最终用户或下游系统。包括:

- 数据分析与BI工具:如 Tableau、Power BI,用于可视化报表和仪表盘。

- 数据API服务:通过API接口为其他应用程序提供数据服务。

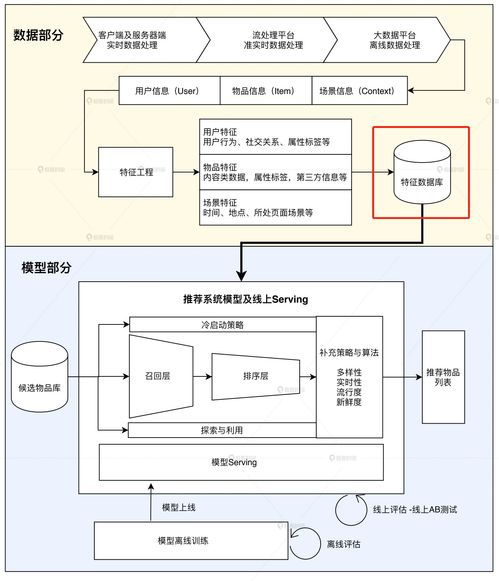

- 机器学习平台:基于处理后的数据训练和部署AI模型。

二、 业务处理流程:从数据到价值的旅程

一个典型的大数据业务处理流程,是数据在上述架构中流动、被加工并最终创造价值的过程。它通常遵循以下阶段:

- 数据产生与接入:业务活动持续产生原始数据,通过采集层工具被实时或定时抽取、汇聚。

- 数据存储与组织:原始数据被加载到数据湖或HDFS中保存。根据业务主题,通过ETL(提取、转换、加载)或更现代的ELT(提取、加载、转换)流程,将部分数据清洗、转换后加载到数据仓库中,形成结构良好的主题域模型(如星型模型、雪花模型)。

- 数据处理与计算:

- 对于离线分析需求,调度系统(如 Apache Airflow)会定时触发批处理作业,进行数据清洗、聚合、关联等复杂计算。

- 对于实时需求,流处理引擎持续消费数据流,进行过滤、窗口统计、模式识别等操作。

- 数据服务与消费:处理后的结果数据被写入到可供高效查询的数据库(如HBase、ClickHouse)或直接推送到应用缓存中。数据分析师通过BI工具进行探索和可视化,业务系统通过API调用获取实时推荐或风险评分,数据科学家在Notebook中训练预测模型。

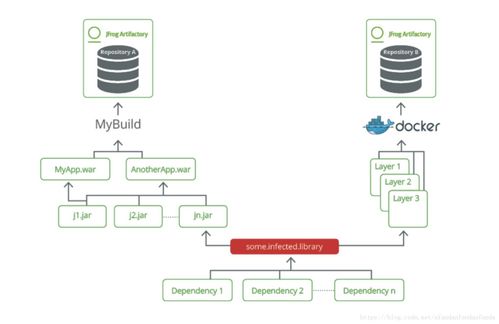

- 数据治理与运维:贯穿整个流程,包括数据质量管理(监控数据准确性、完整性)、元数据管理(记录数据血缘、业务含义)、数据安全(权限控制、脱敏加密)和集群资源监控与优化。

三、 数据处理和存储支持服务:确保体系稳健运行

为了保障大数据架构和流程的高效、稳定运行,一系列关键的支持服务不可或缺:

- 资源管理与调度服务:

- YARN:Hadoop 2.0 的核心组件,作为集群的资源管理和作业调度框架,允许多种计算框架(如MapReduce, Spark)共享集群资源,提高利用率。

- Kubernetes:日益成为云原生大数据平台的事实标准,提供更精细、更灵活的容器化应用部署、伸缩和管理能力。

- 协调与配置服务:

- ZooKeeper:提供分布式协调服务,如统一配置管理、命名服务、分布式锁和集群选举,是 Kafka、HBase 等许多分布式系统正常运行的基础。

- 数据集成与交换服务:

- 除了前文提到的 Kafka、Sqoop,还有如 Apache NiFi,提供可视化的数据流编排,实现强大且可靠的数据系统间路由和转换。

- CDC工具:如 Debezium,用于捕获数据库的变更日志,实现实时数据同步。

- 元数据与数据目录服务:

- Apache Atlas:为 Hadoop 生态系统提供元数据治理和服务,实现数据资产编目、分类、血缘追溯和影响分析。

- 集群监控与运维服务:

- Ambari:提供 Hadoop 集群的供应、管理和监控的Web界面。

- Prometheus + Grafana:现代云原生环境中流行的监控指标收集与可视化组合。

- 安全与权限服务:

- Kerberos:提供强身份认证。

- Apache Ranger 或 Sentry:提供集中的数据安全策略管理,实现细粒度的访问控制(如表、列级权限)。

###

大数据架构、业务处理流程与数据处理及存储支持服务共同构成了一个有机整体。稳健的架构设计是蓝图,清晰高效的流程是价值实现路径,而全方位的支持服务则是确保整个系统能够持续、可靠、安全运行的保障。随着云原生、实时智能等趋势的发展,这三者也在不断演进和融合,为企业从数据中挖掘无限潜能提供着日益强大的动力。

如若转载,请注明出处:http://www.wjstory.com/product/47.html

更新时间:2026-03-03 10:27:05